Introduzione

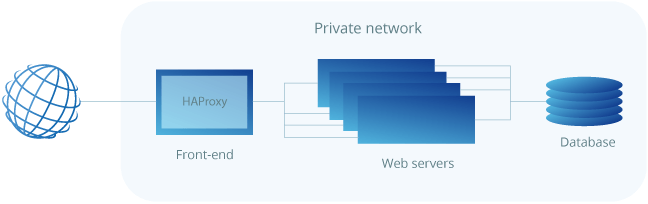

Docker è un’applicazione che rende semplice la possibilità di utilizzare applicazioni all’interno di un container. I container sono simili alle macchine virtuali, però più portabili, e più dipendenti dalla macchina host, in quanto ne condividono le risorse hardware e il kernel.

In questo tutorial vi spiegherò come installare Docker su Ubuntu 16.04.

Prerequisiti

Per questo tutorial avrete bisogno di:

- Installazione di Ubuntu 16.04 su macchina fisica a 64bit

- Utente non root con i privilegi Sudo

Nota: Docker necessita di un’installazione fisica a 64 bit e una versione del kernel uguale o superiore a 3.10. Ubuntu soddisfa le seguenti richieste.

Tutti i comandi di questo tutorial dovrebbero essere lanciati da utenti NON root, se è richiesto l’accesso di root, il comando verrà preceduto da “sudo”.

Step 1: Installare Docker

Il pacchetto di installazione di Docker è presente nei repository ufficiali di Ubuntu 16.04, però potrebbe non essere aggiornato all’ultima versione, per questo è meglio utilizzare il repository ufficiale Docker, dove troveremo sempre le versioni più aggiornate.

Prima di tutto aggiorniamo il database dei pacchetti:

sudo apt-get update

Ora aggiungiamo la chiave GPG del repository di Docker nel portachiavi di sistema:

sudo apt-key adv --keyserver hkp://p80.pool.sks-keyservers.net:80 --recv-keys 58118E89F3A912897C070ADBF76221572C52609D

Aggiungiamo poi il repository di Docker al nostro Ubuntu:

echo "deb https://apt.dockerproject.org/repo ubuntu-xenial main" | sudo tee /etc/apt/sources.list.d/docker.list

Aggiorniamo di nuovo la lista pacchetti:

sudo apt-get update

Sinceriamoci che la versione di Docker che andremo a installare provenga dal repository Docker e non da quello ufficiale Ubuntu:

apt-cache policy docker-engine

Dovreste ottenere un output di questo tipo:

docker-engine:

Installed: (none)

Candidate: 1.11.1-0~xenial

Version table:

1.11.1-0~xenial 500

500 https://apt.dockerproject.org/repo ubuntu-xenial/main amd64 Packages

1.11.0-0~xenial 500

500 https://apt.dockerproject.org/repo ubuntu-xenial/main amd64 Packages

Se tutto è andato come previsto, installiamo Docker:

sudo apt-get install -y docker-engine

A questo punto Docker dovrebbe essere stato installato, abilitato al boot e dovrebbe essere già attivo. Per conoscere lo stato di Docker digitiamo:

sudo systemctl status docker

Questo è l’output che dovremmo ricevere:

● docker.service – Docker Application Container Engine

Loaded: loaded (/lib/systemd/system/docker.service; enabled; vendor preset: enabled)

Active: active (running) since Sun 2016-05-01 06:53:52 CDT; 1 weeks 3 days ago

Docs: https://docs.docker.com

Main PID: 749 (docker)

Installando Docker avrai accesso non solo al demone, ma anche all’utility docker indispensabile per poter configurare/utilizzare Docker.

Vediamo come utilizzare questo comando.

Step 2: Utilizzare Docker senza l’utilizzo di Sudo

Normalmente Docker è un comando che prevede i privilegi di Root, è per questo che dovete sempre usare sudo per poterlo usare. Tale comando però, può essere utilizzato anche dagli utenti che fanno parte del gruppo docker che è automaticamente creato in fase di installazione. Se provate quindi ad utilizzare docker con un utente differente, otterrete il seguente risultato:

docker: Cannot connect to the Docker daemon. Is the docker daemon running on this host?.

See ‘docker run –help’.

Se volete utilizzare Docker con il vostro utente normale, dovrete aggiungervi al gruppo docker:

sudo usermod -aG docker $(whoami)

Dovrete effettuare il logout/login per rendere effettive le modifiche.

Il resto di questo tutorial assume che voi utilizziate Docker tramite un utente limitato appartenente al gruppo docker, pertanto da qui in poi sudo verrà omesso.

Step 3 — Usare il comando docker

Con Docker installato e funzionante, è l’ora di divenire familiare con la sua utility a riga di comando. Utilizzarla – come la maggior parte dei software GNU/Linux – consiste nel passargli una serie di opzioni seguite dai relativi argomenti. La sintassi ha questa forma:

docker [option] [command] [arguments]

Per vedere tutte le opzioni disponibili basterà digitare il comando:

docker

Avrete quindi un output di questo tipo:

attach Attach to a running container

build Build an image from a Dockerfile

commit Create a new image from a container’s changes

cp Copy files/folders between a container and the local filesystem

create Create a new container

diff Inspect changes on a container’s filesystem

events Get real time events from the server

exec Run a command in a running container

export Export a container’s filesystem as a tar archive

history Show the history of an image

images List images

import Import the contents from a tarball to create a filesystem image

info Display system-wide information

inspect Return low-level information on a container or image

kill Kill a running container

load Load an image from a tar archive or STDIN

login Log in to a Docker registry

logout Log out from a Docker registry

logs Fetch the logs of a container

network Manage Docker networks

pause Pause all processes within a container

port List port mappings or a specific mapping for the CONTAINER

ps List containers

pull Pull an image or a repository from a registry

push Push an image or a repository to a registry

rename Rename a container

restart Restart a container

rm Remove one or more containers

rmi Remove one or more images

run Run a command in a new container

save Save one or more images to a tar archive

search Search the Docker Hub for images

start Start one or more stopped containers

stats Display a live stream of container(s) resource usage statistics

stop Stop a running container

tag Tag an image into a repository

top Display the running processes of a container

unpause Unpause all processes within a container

update Update configuration of one or more containers

version Show the Docker version information

volume Manage Docker volumes

wait Block until a container stops, then print its exit code

Per vedere tutte le sotto opzioni dovrete digitare:

docker docker-sottocomando --help

Per vedere le informazioni generali dovrete digitare:

docker info

Step 4: Lavorare con le immagini docker

I container Docker vengono sviluppati dalle immagini Docker. Normalmente si possono prendere delle immagini preconfigurate direttamente dal Docker Hub, un repository di immagini gestito dalla società che ha creato Docker. Molte volte troverete l’immagine che cercate direttamente nel Docker Hub.

Per controllare il corretto accesso al Docker Hub digitate:

docker run hello-world

L’output che dovreste ricevere è:

Hello from Docker.

This message shows that your installation appears to be working correctly.

Potete cercare le immagini Docker utilizzando il comando search:

docker search ubuntu

Lo script prenderà i dati dal Docker Hub e vi restituirà un output simile a questo:

NAME DESCRIPTION STARS OFFICIAL AUTOMATED

ubuntu Ubuntu is a Debian-based Linux operating s… 3808 [OK]

ubuntu-upstart Upstart is an event-based replacement for … 61 [OK]

torusware/speedus-ubuntu Always updated official Ubuntu docker imag… 25 [OK]

rastasheep/ubuntu-sshd Dockerized SSH service, built on top of of… 24 [OK]

ubuntu-debootstrap debootstrap –variant=minbase –components… 23 [OK]

nickistre/ubuntu-lamp LAMP server on Ubuntu 6 [OK]

nickistre/ubuntu-lamp-wordpress LAMP on Ubuntu with wp-cli installed 5 [OK]

nuagebec/ubuntu Simple always updated Ubuntu docker images… 4 [OK]

nimmis/ubuntu This is a docker images different LTS vers… 4 [OK]

maxexcloo/ubuntu Docker base image built on Ubuntu with Sup… 2 [OK]

admiringworm/ubuntu Base ubuntu images based on the official u… 1 [OK]

Una volta che hai identificato l’immagine che ti interessa, la puoi scaricare tramite il comando pull:

docker pull ubuntu

Una volta che l’immagine è stata scaricata, potete utilizzarla utilizzando l’istruzione run

docker run ubuntu

Per avere una lista delle immagini scaricate, utilizzate l’istruzione images:

docker images

Dovreste ricevere un output simile a questo:

REPOSITORY TAG IMAGE ID CREATED SIZE

ubuntu latest c5f1cf30c96b 7 days ago 120.8 MB

hello-world latest 94df4f0ce8a4 2 weeks ago 967 B

Queste immagini potranno poi essere modificate per creare altre immagini Docker, ed essere inviate (pushed) al Docker Hub e ad altri registry Docker.

Step 5: Utilizzare un container Docker

Prendendo come esempio l’immagine di Ubuntu scaricata in precedenza, utilizzatela facendo il deploy di un nuovo container:

docker run -it ubuntu

le opzioni -i e -t vi forniranno una console interattiva collegata al container.

Il prompt dei comandi quindi dovrà cambiare, in questo modo si entrerà dentro il container:

root@d9b100f2f636:/#

Come vedete, potete lavorare all’interno del container con le credenziali di root.

A questo punto, potete lavorare dentro al container utilizzando le più comuni utility GNU/Linux. Ad esempio installiamo postfix:

apt-get install -y postfix

Step 6: Controllare i tuoi container

Dopo aver utilizzato Docker per un po’, avrete diversi container attivi o meno. Per vedere i container attivi digitate:

docker ps

Avrete un output simile a questo.

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

f7c79cc556dd ubuntu “/bin/bash” 3 hours ago Up 3 hours silly_spence

Per vedere tutti i container, attivi e passivi digitate:

docker ps -a

Per vedere l’ultimo container creato digitate:

docker ps -l

Per fermare un container digitate:

docker stop container-id

Il container-id può essere trovato utilizzando il comando docker ps

Conclusione

Docker è uno strumento molto completo, e c’è molto da imparare per poterlo usare al meglio. Con questo tutorial però potrete già iniziare a usare Docker per i vostri progetti o per apprendimento.

Liberamente tratto da Digital Ocean